2025 年末,硅谷传出一则打破传统估值逻辑的消息:开源项目 vLLM——一个甚至没有正式官网、没有商业模式、营收几乎为零的 GitHub 代码库,正在洽谈一轮 1.6 亿美元 的融资,估值直逼 10 亿美元独角兽门槛。

当红杉(Sequoia)等顶级资本开始为“免费代码”买单,这不仅仅是一次疯狂的下注,更是一个明确的信号:AI 行业的重心正在从“卷模型”全面转向“卷推理”。谁能把大模型的运行成本打下来,谁就是下一个时代的“英伟达”。

一、 行业拐点:当“训练”见顶,“推理”称王

过去两年,资本市场的热钱都涌向了 OpenAI、Anthropic 这样的模型层。大家的逻辑是:“谁的模型聪明,谁就赢。”

然而,2025 年的数据正在打脸:

- 训练成本边际递减:大模型的能力提升进入瓶颈期,边际效应递减。

- 推理成本指数爆炸:随着企业开始大规模应用 AI(从 Chatbot 到 Agent),“运行模型”的成本(Inference Cost) 开始超过“训练模型”的成本。

- 痛点:企业发现,租用 H100 GPU 来跑 Llama 3 的费用,正在吞噬掉所有的利润。

vLLM 的上位逻辑:

vLLM 不是大模型,它是让大模型“跑得更快、更省显存”的加速器。

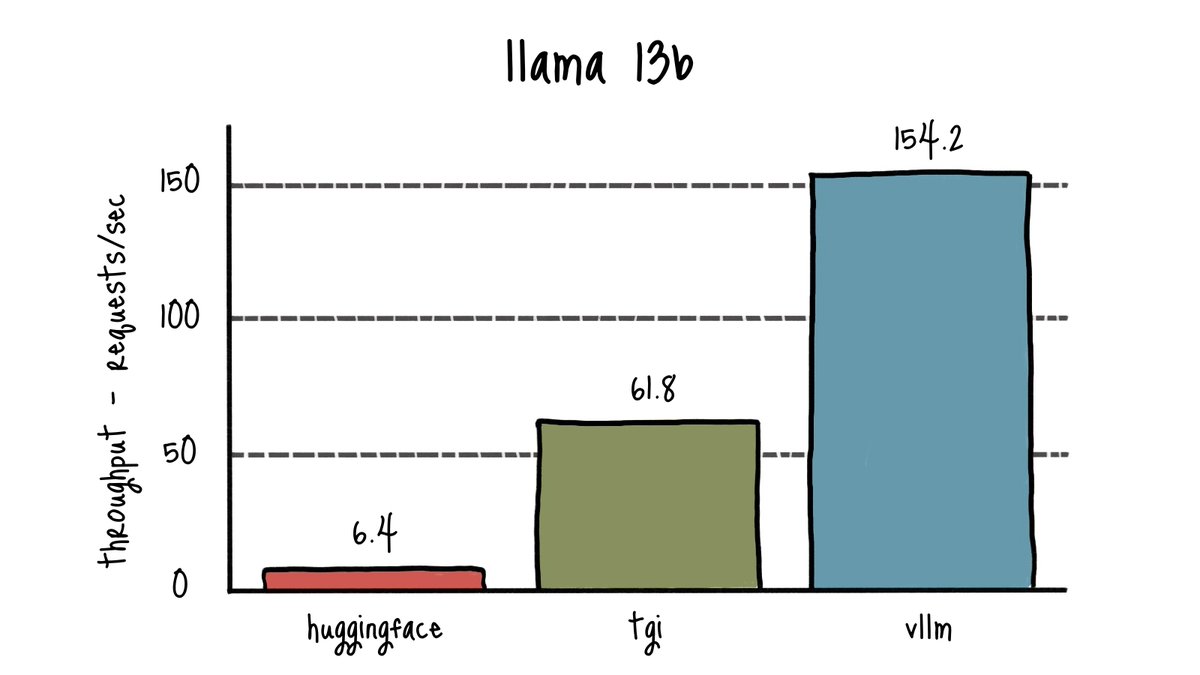

图 1:速度就是金钱。 在同样的硬件上,vLLM 的吞吐量(Throughput)是传统框架的 2 -4倍。对于企业来说,这意味着原本需要买 4张显卡才能干完的活,现在 1 张就够了。(来源:vLLM Blog)

核心技术:PagedAttention。

它像操作系统的“虚拟内存”一样,极度高效地管理 GPU 显存。

- 效果:原本一块 GPU 只能服务 10 个人,用了 vLLM 能服务 24 人了。这意味着企业的 GPU 账单直接砍半。

- 这就是为什么它没有收入却值 10 亿美金——它掌握了 AI 时代的“降本增效”阀门。

二、 底层逻辑:不要“卖水”,要“卖水管”

为什么资本愿意投一个开源、免费的项目?我们需要拆解其背后的生态卡位(Ecosystem Play)。

1. “Databricks 帮”的降维打击

vLLM 并非草根项目,它背后的实验室由 Ion Stoica(Databricks 联合创始人)领导。

- 历史押韵:Databricks 当年就是基于开源的 Spark 建立的千亿美金帝国。

- 逻辑复刻:先用开源(vLLM)占领开发者的认知,成为行业标准(Standard);再通过托管服务(Managed Service)或企业版(Enterprise Features)进行收割。

- 资本视角:投资 vLLM,本质上是在赌它能成为 AI 推理时代的 Linux。一旦所有的大模型都默认跑在 vLLM 上,它就拥有了对整个生态的定价权。

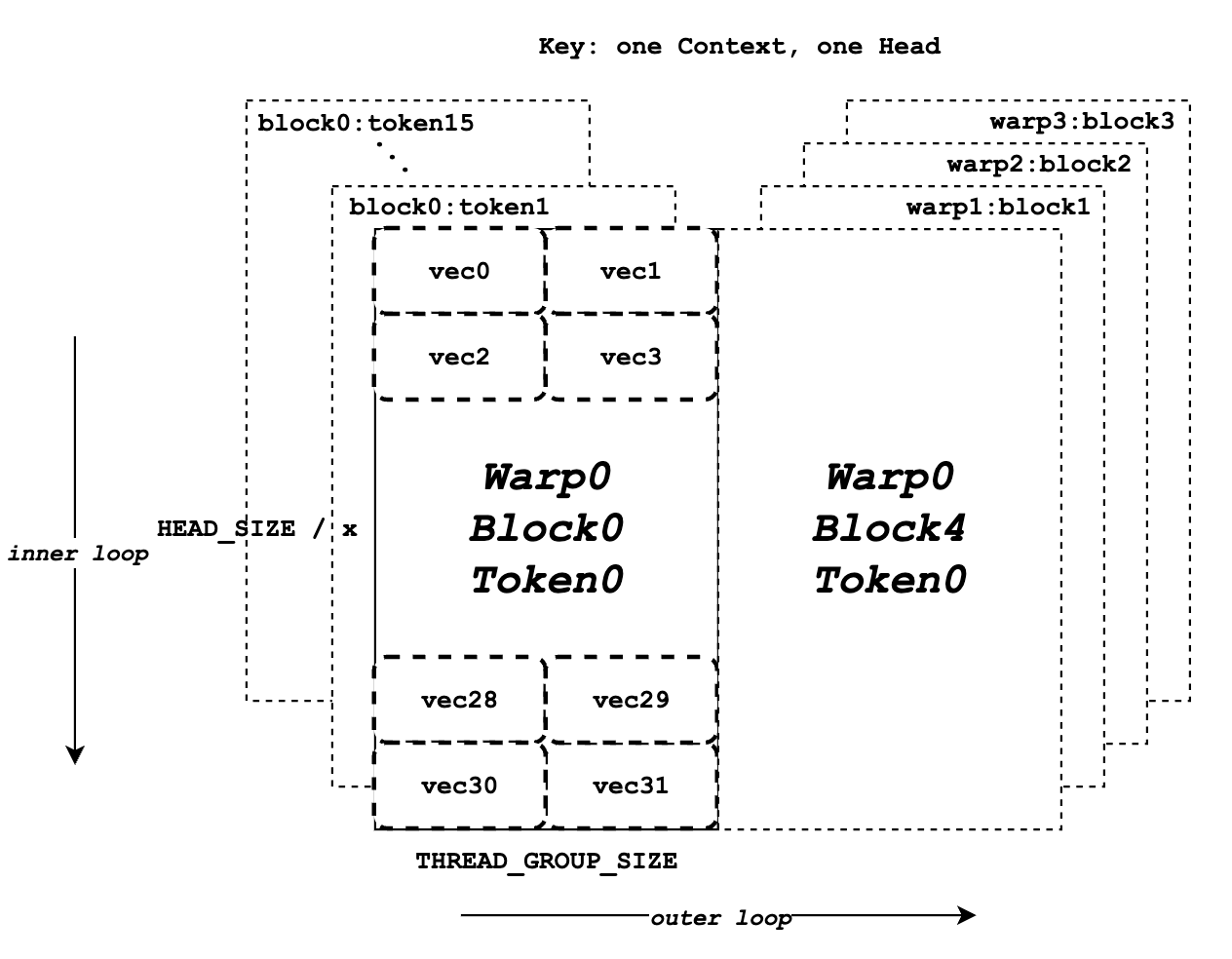

图 2:GPU 显存的“俄罗斯方块”。 传统技术会让显存像瑞士奶酪一样充满空洞(浪费),而 vLLM 的 PagedAttention 技术能将每一寸昂贵的显存“榨干”。这就是它 10 亿美金估值的技术地基。(来源:vLLM 论文)

2. 算一笔“推理经济学”的账

目前的 AI 基础设施存在巨大的价值倒挂:

- 模型层:卷价格战,API 价格越来越低(OpenAI 都在降价)。

- 算力层:英伟达一家独大,显卡价格居高不下。

- 中间层(vLLM 的机会):谁能填补“便宜的模型”和“昂贵的显卡”之间的鸿沟?

- Value:如果 vLLM 能让一张 H100 的利用率从 30% 提升到 80%,它就变相为客户创造了数百万美元的价值。这种价值,远比卖软件订阅(SaaS)更有意义。

三、 赛道格局:推理赛道的“战国时代”

vLLM 虽然是当红,但并非没有对手。推理优化赛道正在经历一场神仙打架。

玩家类型 | 代表公司 | 核心逻辑 | 资本动作 |

开源标准派 | vLLM | 社区驱动。依靠伯克利光环和极高的吞吐量(Throughput),成为开发者的默认选项。 | 拟融资 1.6 亿美金,估值 10 亿。 |

商业闭环派 | Fireworks AI, Together AI | 服务驱动。不仅提供优化技术,直接卖 API 服务,商业化跑得更快。 | 估值均已数十亿美金,收入可观。 |

硬核技术派 | SGLang (RadixArk) | 极致性能。同样源自伯克利,专注于更复杂的长文本推理,技术上与 vLLM 贴身肉搏。 | 估值 4 亿美金,正在快速崛起。 |

硬件巨头派 | NVIDIA (TensorRT-LLM) | 生态闭环。英伟达自己的加速库,性能最强,但绑定硬件,不够灵活。 | 它是所有人的“假想敌”。 |

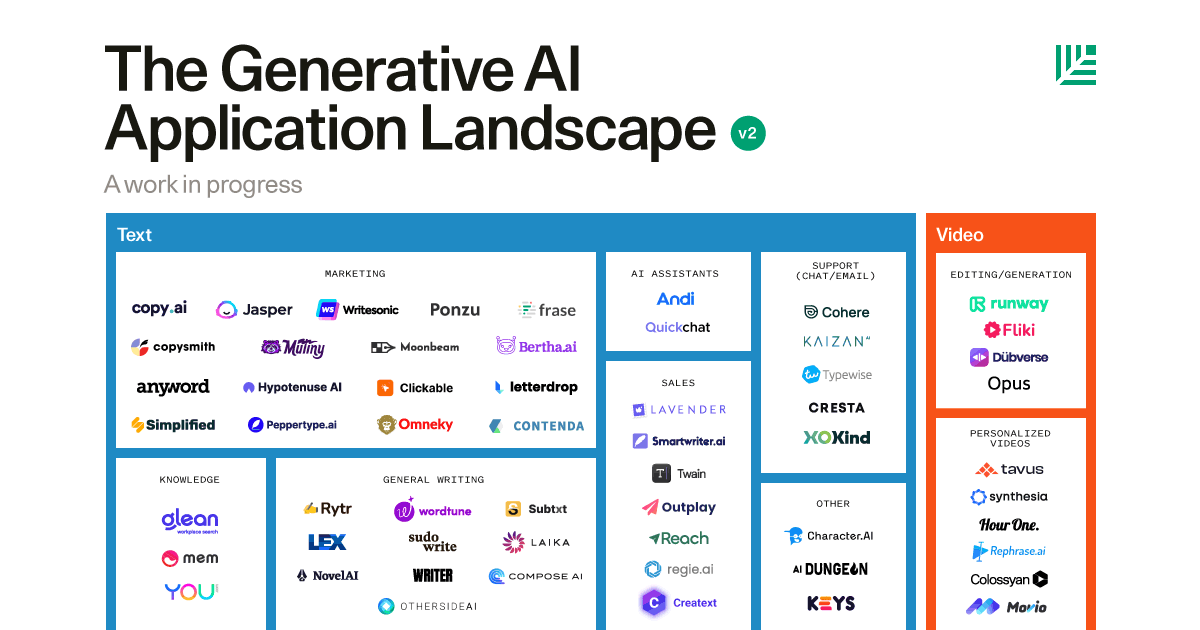

图 3:万亿赛道的入场券。 在 AI 基础设施图谱中,“推理层(Inference)”正在变得拥挤不堪。vLLM 正在试图从一堆 Logo 中杀出重围,成为唯一的“操作系统”。

终局推演:

短期内,vLLM 会继续“烧钱”扩大社区影响力,挤压闭源竞品的生存空间。未来 3 年,推理市场将出现分化:通用推理走 vLLM(标准化),高端/专用推理走垂直厂商。

四、 氪金建议:给创业者与投资人的“红线”与“红利”

站在 2026 年初的视角,vLLM 的融资事件给行业带来了什么启示?

- 红利:InferenceOps(推理运维)是金矿

- Action:别再去卷“训练大模型”了,那是巨头的游戏。

- 机会:去围绕 vLLM 做周边生态。比如“vLLM 的企业级监控”、“基于 vLLM 的私有化部署方案”。淘金热里,卖铲子的赚翻了;现在,卖“铲子维修服务”的也能赚翻。

- 红线:警惕“纯工具”陷阱

- Warning:vLLM 之所以能融资,因为它是标准。如果你只是做一个“好用的小工具”,没有社区壁垒,很容易被巨头吞并或被开源替代。

- 判断:你的技术壁垒,能否在开源社区的“饱和式攻击”下存活 6 个月?

- 战略:关注“Token 经济学”

- Insight:未来的企业 IT 预算,将从“按人头付费(SaaS)”转向“按 Token 付费”。

- 建议:所有软件企业,都必须学会算清楚自己的Unit Economics(单 Token 成本)。谁能把这个成本压得更低,谁就有定价权。

结语

vLLM 的 10 亿估值,撕开了 AI 商业化的一角真相:收入、代表过去,生态、代表未来。

在 AI 算力极其昂贵的今天,任何能帮企业“省显卡”的技术,都是在印钞票。对于 vLLM 来说,即使现在分文不取,只要它成为了 AI 时代的“血管”,未来整个行业都要为它输血。