AI Ping上新GLM-4.7_MiniMax M2.1,保姆级调用教程来袭

@[TOC]📢 国内大模型聚合平台AI Ping正式上线GLM-4.7与MiniMax M2.1两款旗舰模型免费体验,Token不限量!无论是复杂工程编码、长链Agent开发,还是多语言项目实现,这两款模型都能精准适配。本文将带你全面解析模型优势,并附上API调用、Claude Code/Coze集成的保姆级操作指南,手把手教你玩转新一代国产大模型。👉 官方入口:AI Ping注册登录立享30元算力金

一、先搞懂:AI Ping平台核心优势

在开始使用模型前,先了解下AI Ping的核心价值——作为国内领先的大模型服务评测与聚合平台,它就像一个“大模型超市”,解决了开发者跨平台调用的痛点:

- 📊 全量模型覆盖:已接入智谱、MiniMax、DeepSeek等主流厂商,涵盖95+模型,支持文本生成、视觉理解、图像生成等多种类型;

- 🔌 统一接口调用:一套OpenAI兼容接口切换所有供应商,零成本适配现有开发框架;

- 📈 性能可视化:实时展示吞吐、延迟、价格、可靠性等关键指标,选型更透明;

- 🛡️ 智能路由:高峰时段自动选择最优供应商,保障服务稳定性;平台首页直观展示两款新模型,点击“去使用”即可快速接入:![[图片]](https://i-blog.csdnimg.cn/direct/4653ed07c8374295a210e79579b08963.png)

二、模型深度解析:GLM-4.7 vs MiniMax M2.1,怎么选?

两款模型均为国产旗舰级,但定位差异明显,精准覆盖不同开发场景。先通过核心参数和适用场景快速选型:

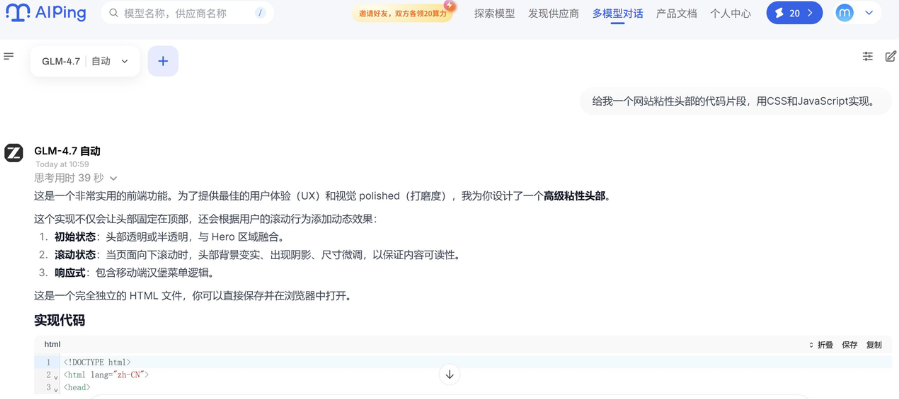

1. GLM-4.7:复杂工程交付的“前端利器”

GLM-4.7是智谱最新旗舰模型,主打Agentic Coding场景,核心优势聚焦“一次性复杂工程交付”:

- ✨ 核心能力:强化编码能力、长程任务规划与工具协同,可控推理机制保障复杂任务稳定交付;

- 📋 关键参数:128K~200K上下文长度,输入输出全免费,支持多家供应商(智谱官方、七牛云等),智谱官方延迟低至0.61s,吞吐50.31 tokens/s;

- 🎯 适用场景:复杂编码任务、Artifacts前端生成、项目初始化、核心架构设计。

使用测试

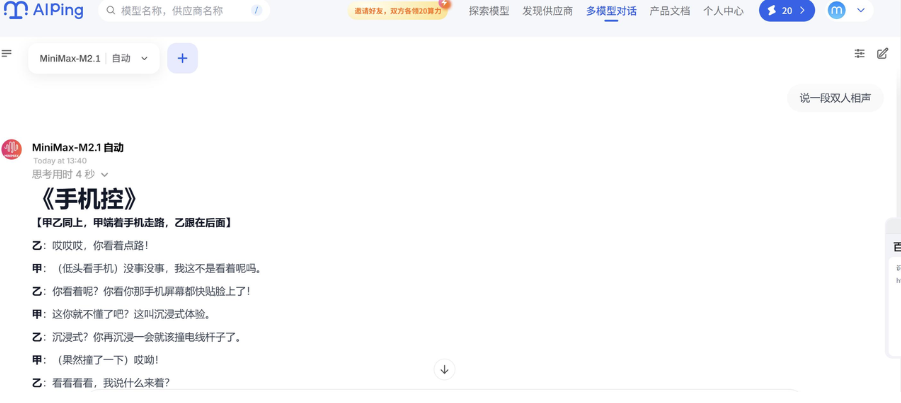

2. MiniMax M2.1:长链Agent的“后端强援”

MiniMax M2.1面向长链Agent执行场景,核心优势是“持续运行效率与多语言能力”:

- ✨ 核心能力:基于高效MoE架构,强化Rust/Go/Java/C++等生产级代码支持,推理路径更收敛,工具调用更高效;

- 📋 关键参数:200K上下文长度,输入输出全免费,MiniMax官方延迟0.72s,吞吐89.56 tokens/s,七牛云供应商吞吐更是高达99.75 tokens/s;

- 🎯 适用场景:长链Agent工作流、多语言后端工程、持续迭代优化、长时间运行任务。![[图片]](https://i-blog.csdnimg.cn/direct/962441d5df50462886db15ec970a771a.png)

使用测试

3. 快速选择

是否需要生成前端/UI?├── 是 → GLM-4.7└── 否 → 是否涉及 Rust/Go/Java/C++ 等后端语言? ├── 是 → MiniMax M2.1 └── 否 → 任务是否需要长时间持续运行? ├── 是 → MiniMax M2.1 └── 否 → 是否需要一次性完成复杂工程交付? ├── 是 → GLM-4.7 └── 否 → 两者均可,按个人偏好选择 将这部分内容进行修改 更改和原文内容不一样的

三、前置准备:获取AI Ping API Key

所有调用方式的前提是获取API Key,步骤超简单:

- 通过专属链接注册并登录AI Ping平台;

- 进入平台右上角【个人中心】→ 【API Key】页面;

- 直接复制已生成的API Key(长期有效),同时记录OpenAI兼容BaseURL:https://aiping.cn/api/v1;

- ⚠️ 重要提醒:API Key是调用凭证,切勿公开分享,建议定期轮换。

四、保姆级使用教程:3种调用方式任选

AI Ping支持统一的OpenAI兼容接口,同时可集成到Claude Code、Visual Studio Code等主流开发工具,以下是详细操作步骤。

方式1:直接API调用(Python示例)

适用于快速测试和自定义开发,支持GLM-4.7和MiniMax M2.1,仅需修改model参数即可切换模型:

✅ 测试验证:运行代码后,若实时输出脚本内容,说明调用成功。

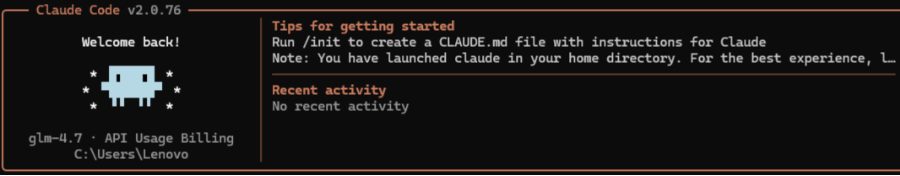

方式2:Claude Code中集成GLM-4.7

适合习惯用Claude Code编程的开发者,需配置环境变量关联AI Ping接口:

步骤1:安装环境

确保已安装Node.js(建议v24+),然后全局安装Claude Code:

步骤2:修改配置文件

- 找到配置文件路径:Windows系统为 C:\Users\你的用户名.claude\settings.json,Mac/Linux为 ~/.claude/settings.json;

- 替换配置内容(将API Key替换为自己的):

步骤3:启动使用

在终端输入以下命令启动Claude Code,即可直接使用GLM-4.7进行编程:

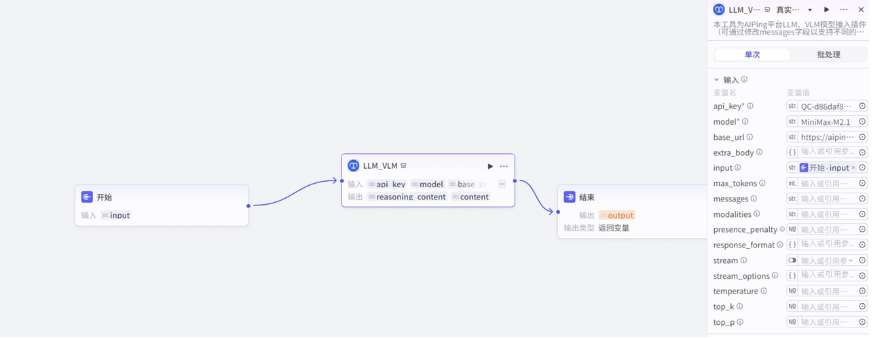

方式3:Coze中集成MiniMax M2.1

Coze(扣子)是字节跳动AI Bot开发平台,通过AI Ping插件可快速集成MiniMax M2.1,适用于构建智能体应用:

步骤1:安装AI Ping插件

- 登录Coze官网(https://www.coze.cn/),进入左侧【插件市场】;

2.搜索“AIPing-official-plugin”,点击进入插件详情页;![[图片]](https://i-blog.csdnimg.cn/direct/baef03f1eb1a4c9389d0bc573d2dba8c.png)

3. 点击右上角【收藏】,方便后续快速调用。

步骤2:创建智能体与工作流

- 返回Coze首页,点击【创建智能体】,填写名称(如“MiniMax-M2.1智能助手”)和描述;

- 进入智能体编辑页,点击【工作流】标签,选择【+ 添加新工作流】→【从空白创建】。

步骤3:配置插件节点

- 在工作流编辑器中点击【+ 添加节点】,选择【插件】→【我的收藏】,找到并添加“AIPing-official-plugin”;

- 点击插件节点,配置核心参数:

- api_key:填写你的AI Ping API Key;

- model:填写“MiniMax-M2.1”;

- base_url:填写“https://aiping.cn/api/v1”;

- 其他参数(可选):stream(是否流式输出)、temperature(0-1,控制随机性)、max_tokens(最大生成token数)。

步骤4:测试与发布

- 点击右上角【试运行】,输入测试指令(如“用Go写一个简单的HTTP服务”);

- 查看运行结果,确认模型返回符合预期后,点击【发布】即可正式使用。⚠️ 提示:将model参数改为“GLM-4.7”,即可切换使用GLM模型。

方式4:Roo Code+VSCode中集成GLM-4.7/MiniMax M2.1

Visual Studio Code(VS Code)作为开发者最常用的编辑器,可通过OpenAI兼容插件快速集成AI Ping的两款模型,实现代码生成、注释优化、需求拆解等功能,无需切换窗口即可调用模型能力。以下是具体集成步骤:

步骤1:安装OpenAI兼容插件

推荐使用应用广泛的“Roo Code”插件(支持OpenAI接口协议,可直接适配AI Ping),安装步骤如下:

- 打开VS Code,点击左侧【扩展】图标(或快捷键Ctrl+Shift+X);

- 在搜索框输入“Roo Code”,找到对应插件后点击【安装】;

- 安装完成后,左侧会出现袋鼠图标,点击进入配置界面。点击插件右下角【设置】图标,进入插件配置页。![[图片]](https://i-blog.csdnimg.cn/direct/53d98177135a4202abf91e2ec78a3527.png)

步骤2:配置插件关联AI Ping接口

Roo Code本身并不直接提供AI模型,它需要调用第三方的大语言模型API来生成代码和建议。因此,安装插件后,下一步是配置模型和API密钥。Roo Code支持多种模型和API提供商,包括OpenAI、Anthropic、Google Gemini,以及国内的DeepSeek、百川等,甚至可以连接本地部署的模型。下面以接入AI Ping为例,介绍配置流程:核心是将插件的接口地址、API Key指向AI Ping平台(利用其OpenAI兼容特性),具体配置:

- 在插件配置页找到【API Settings】模块,展开后设置以下参数:

- API Provider:选择“OpenAI”(因AI Ping兼容OpenAI协议);

- API Key:输入你的AI Ping API Key;

- Custom API Endpoint:输入AI Ping的OpenAI兼容BaseURL:

https://aiping.cn/api/v1/chat/completions; - Model:先默认留空,后续测试时手动指定(支持动态切换GLM-4.7和MiniMax M2.1)。

- 配置完成后,点击【Save Settings】保存,重启插件生效(可通过VS Code左下角【设置】→【扩展】→【Roo Code】再次检查配置)

步骤3:测试GLM-4.7调用

- 新建一个空白文件(快捷键Ctrl+N),任意输入测试需求,比如“用Python写一个批量读取CSV文件的函数”;

- 选中输入的需求文本,右键点击选择【Roo Code】;

- 在弹出的输入框中,手动指定模型:输入“model: GLM-4.7”,然后按回车发送请求;

- 等待1-3秒,插件会在下方输出面板返回模型生成的代码,同时支持直接插入到当前文件中(点击输出面板的【Insert Code】按钮)。✅ 测试验证:若生成的代码包含完整的函数定义、参数说明和使用示例,说明GLM-4.7集成成功。

步骤4:切换测试MiniMax M2.1

无需修改插件配置,仅需在调用时切换模型参数即可:

- 在VS Code中输入新的测试需求,比如“用Go语言实现一个简单的Redis连接工具类”;

- 选中文本后右键选择【ChatGPT: Ask Code GPT】;

- 在输入框中指定模型:输入“model: MiniMax-M2.1”,按回车发送;

- 查看输出面板的结果,验证代码的完整性和准确性。注意事项:1. 若调用失败,检查API Key是否正确、网络是否通畅,可在VS Code【查看】→【输出】→【ChatGPT - Code GPT】中查看错误日志;2. 支持自定义生成参数,比如在输入框中添加“temperature: 0.6, max_tokens: 2048”来控制输出随机性和长度。

五、获取算力

- 📤 链接:

https://aiping.cn/#?channel_partner_code=GQCOZLGJ - 💡 算力金用途:全场模型通用,可用于GLM-4.7、MiniMax M2.1等所有模型的调用,无使用门槛。

六、总结

AI Ping本次上新的GLM-4.7和MiniMax M2.1,分别补齐了复杂工程交付和长链Agent开发的核心需求,统一的OpenAI兼容接口,对开发者来说性价比拉满。无论是个人学习、项目开发还是企业级应用,都能快速接入使用。推荐体验国产旗舰大模型的强大能力吧!如果在使用过程中有任何问题,欢迎在评论区留言交流~🔗 相关链接:

- AI Ping官方首页:https://aiping.cn/

- 官方API文档:https://aiping.cn/api-docs

- Coze官方平台:https://www.coze.cn/