微软 CEO 纳德拉刚刚宣布,微软自研的第二代 AI 芯片 Maia 200,现已正式在 Azure 上线。

这款基于台积电 3nm 工艺打造的芯片,拥有 1400 亿晶体管,每美元性能比微软现有系统提升了整整 30%。

过去微软要向英伟达支付昂贵的 AI 推理成本,但现在,微软决定自己造芯片了。

纳德拉推特官宣 Maia 200 上线

一、 不给黄仁勋打工了

过去的两年里,全球 AI 行业似乎只为一家公司转动,英伟达(Nvidia)。从 H100 到 Blackwell,每一块显卡都被视为硬通货,被马斯克称为“算力黄金”。

但对于微软来说,这是一种甜蜜的痛苦。

黄仁勋与标志性皮夹克

作为 OpenAI 最大的金主和 Azure 的掌舵者,微软每个季度都在向英伟达支付数百亿美元。据财报显示,微软 2026 财年第一财季的资本支出达到了创纪录的 349 亿美元,其中约一半都用来购买 GPU 和 CPU。

这对于资本巨头也是一笔天文数字,更要命的是,随着 ChatGPT 和 Copilot 的用户数突破 9 亿,AI 的成本还在发生质的变化。

在 AI 发展的早期,成本主要集中在训练,这是一次性投入,虽贵但可控。但现在,成本的大头变成了推理,即模型每天回答 9 亿用户的提问。

这是一个无底洞。每生成一个 Token,每回答一个问题,都在烧钱。

如果继续全盘依赖英伟达,微软实际上是在给黄仁勋打工。为了打破这个死循环,微软必须拥有自己的印钞机。

Maia 200 就是这台机器。

微软 CEO 纳德拉在访谈中直言不讳:“我们的计划是在自己的 AI 模型和芯片之间建立一个闭环。”

潜台词是:我不想被任何人卡脖子,无论是产能,还是价格。

二、 1400 亿晶体管的暴力美学

那么,Maia 200 到底强在哪里?

Maia 200 官方宣传演示

如果说英伟达的 GPU 是全能王,既能训练也能推理,什么都能干,但价格昂贵;那么 Maia 200 就是微软培养的特种兵,它专注于高效的推理。

1. 参数

- 工艺制程: 采用台积电 3nm 工艺。这是目前量产芯片的巅峰,塞进了 1400 亿 个晶体管。作为对比,英伟达的上一代 H100 只有 800 亿晶体管。

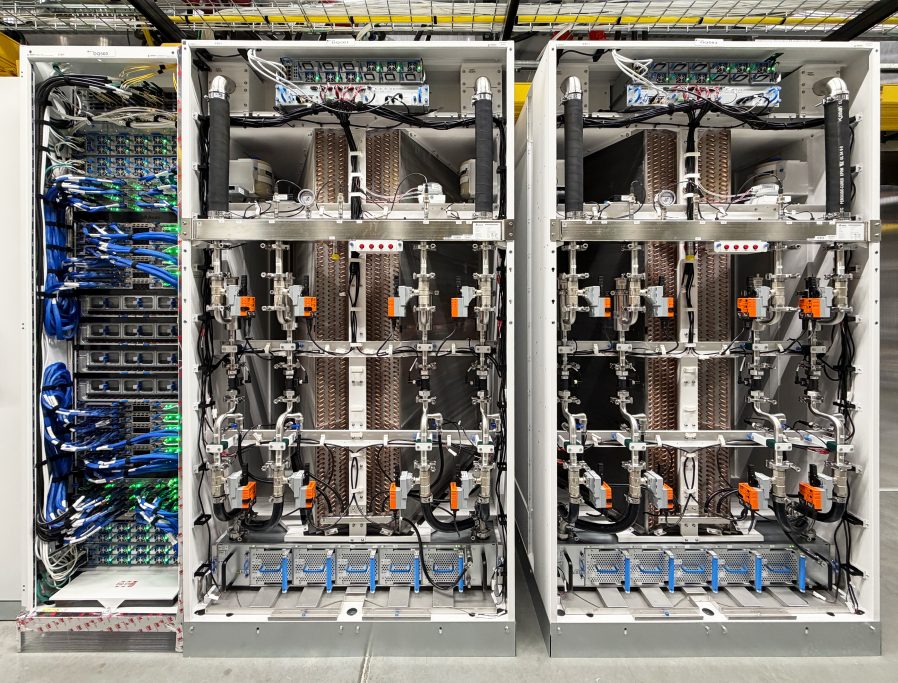

- 内存猛兽: 配备 216GB 的 HBM3e(高带宽内存),带宽高达 7TB/s。这意味着什么?这意味着 Maia 200 可以把巨大的 GPT-4 或 GPT-5 模型一口气塞进进显存里,而不需要频繁地在硬盘和内存之间搬运数据。

- 极致算力: 其 FP4 性能是亚马逊最新一代 Trainium 3 的 3 倍。

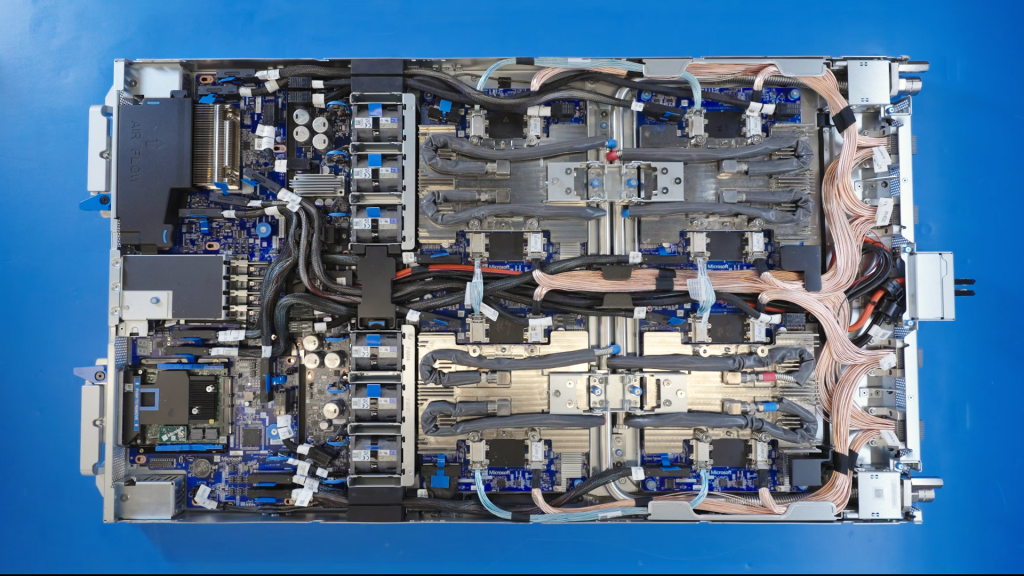

Maia 200 液冷机架细节

2. 私房菜

英伟达的 GPU 是卖给全世界用的,它必须照顾到各种场景,就像外卖,一直点一家,永远一个味儿。

而 Maia 200 是微软为 OpenAI 量身定制的私房菜。微软拥有 OpenAI 的源代码,它比任何人都清楚 GPT 模型需要什么样的算力。

这就和 PS5 一样,也许显卡不如顶配电脑,但各个游戏厂商会做定制优化,用户体验并不差。

对于微软的财务报表来说,这只是为了把 Copilot 每次对话的成本从 1 美分降到 0.7 美分。乘以 9 亿用户,这就是数十亿美元的利润。

Maia 200 服务器单板渲染图

三、 围攻光明顶

Maia 200 的上线,标志着云厂商对英伟达的围剿进入了新阶段。

不仅仅是微软,谷歌早就有了 TPU,并且已经迭代到了第六代(Trillium),支撑着自家的 Gemini 模型;亚马逊 AWS 也在疯狂推销自家的 Trainium 和 Inferentia 芯片,试图用低价吸引客户。

大家都在做同一件事:训练用英伟达(没得选),推理用自研(省钱,能闭环)。

微软 Azure AI 数据中心实景

这就是目前 AI 芯片市场的格局:

- 英伟达依然是王。 在通用性、软件生态(CUDA)和巅峰性能上,它拥有绝对的实力。对于大多数公司和科研机构来说,英伟达是唯一的选择。

- 但微软们正在挖墙脚。 它们通过混合部署策略,把那些确定性强、规模巨大的内部负载(如 ChatGPT、Office 365 Copilot)转移到自研芯片上。

微软超级智能团队负责人苏莱曼已经表态,他的团队将利用 Maia 200 进行合成数据生成和强化学习。这说明 Maia 200 已经是主力军。

四、 结尾

AI 竞争的下半场,成本控制成了生死线。

如果 Copilot 的订阅费是 20 美元,而背后的算力成本是 15 美元,那就是个苦力活;如果有了 Maia 200,成本降到了 10 美元,就成了印钞机。

能够把推理成本打下来,或许更能让纳德拉睡得安稳。因为在商界,省下来的每一分钱,都是利润。

现在还只是开始,而 Maia 200,就是微软射向英伟达的第一颗子弹。