塔猴 2 月 11 日报道,就在刚刚,科大讯飞的讯飞星火大模型 X2(Spark X2)正式发布!

距离上一个版本 X1.5 发布仅仅过去了 3 个月,在 GLM-5 刚刚引爆春节热度后,讯飞星火 X2 用完全国产算力和超强推理能力再次刷新了国产大模型的天花板。

这次升级有多硬核?

- 算力全自主:基于全国产算力(昇腾服务器)训练,不再依赖英伟达,实现完全自主可控

- 性能狂飙:采用 293B MoE 稀疏架构,推理性能飙升 50%,训练效率提升超 50%

- 对标顶尖:在数学、逻辑推理能力上,直接硬刚 GPT-5.2 和 Gemini-3-Pro

- 开卷福利:API 接口全面开放,100 万 Tokens 免费送,开发者狂喜

塔猴第一时间梳理了讯飞星火 X2 的核心看点,看看在这次春节模型大战,讯飞是如何用技术和应用突围的。

体验链接指路:

一、啃下国产算力硬骨头

在当前的国际环境下,算力是最大的瓶颈。而星火 X2 最大的底气,就是去英伟达化。

讯飞星火 X2 是完全基于国产算力底座(如昇腾服务器)完成训练的,不仅意味着数据安全,更意味着中国大模型在基础设施上站稳了脚跟。

但国产算力的适配并非易事。为了解决算力利用率问题,讯飞研发团队在算法架构上下了大功夫。星火 X2 采用了 293B MoE(混合专家)稀疏架构。

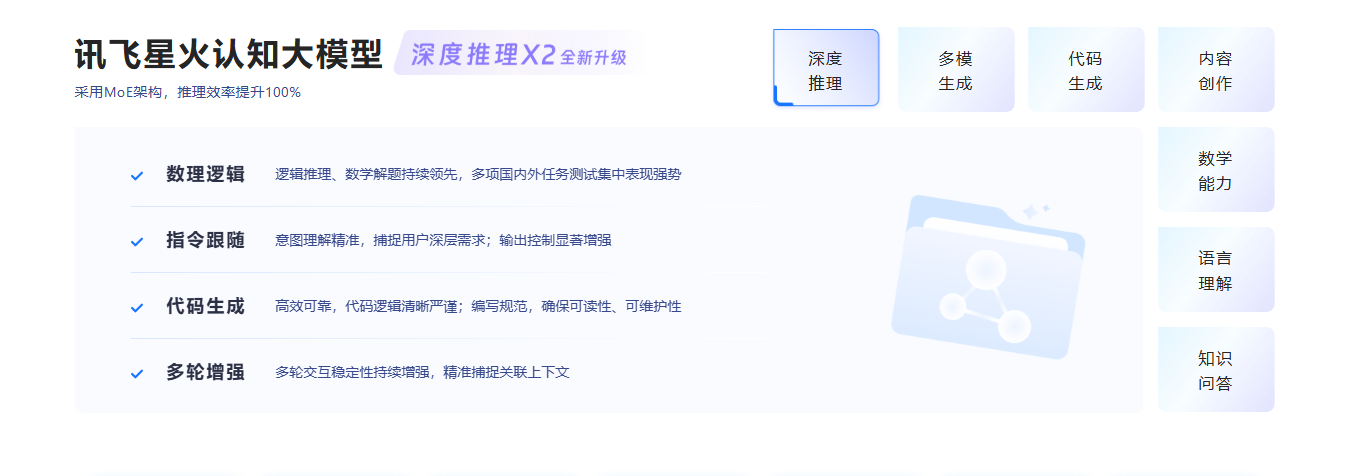

通用大模型核心能力对比

仅仅堆参数是不够的,关键在于如何让模型跑得更快。

讯飞通过权重量化、低精度 KV Cache 以及 VTP 等一系列黑科技,将单台服务器的运行效率推向了极致。

结果就是,在同样的硬件条件下,星火 X2 的推理性能相比前代暴涨 50%。这让企业在部署模型时,成本将大幅下降,响应速度却更快。

二、数理逻辑逼近满分

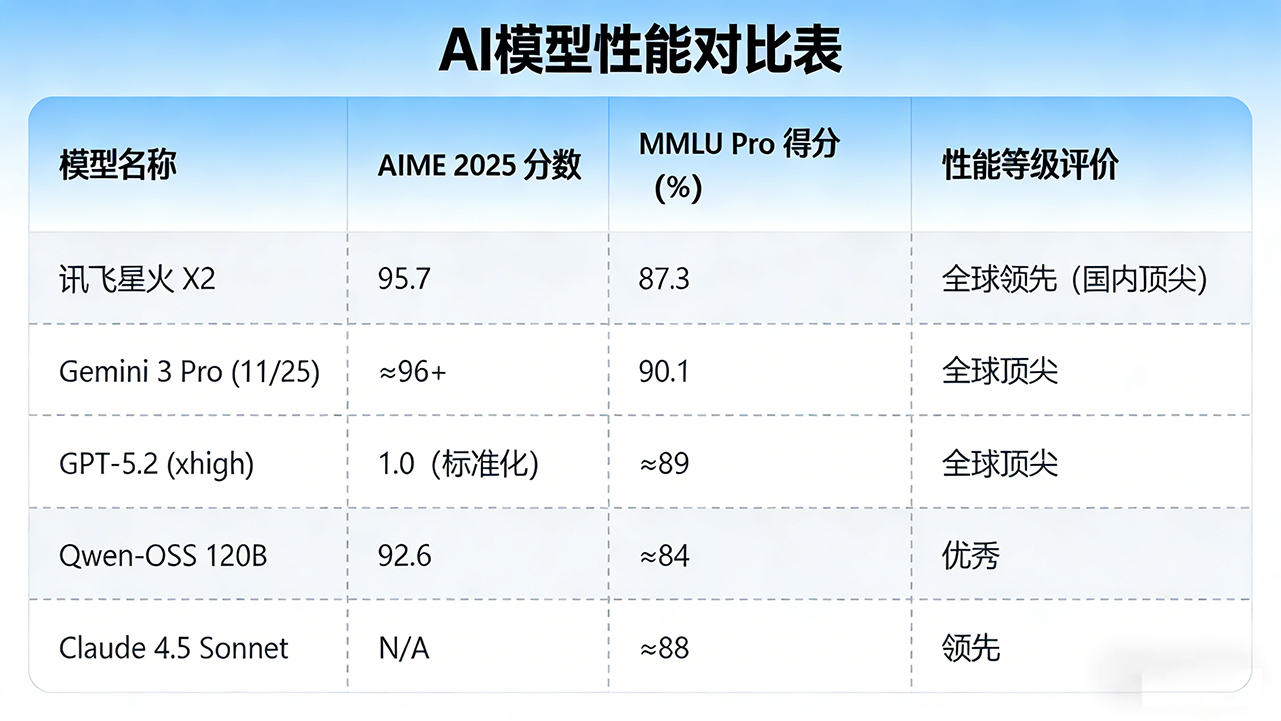

不服跑个分?星火 X2 这次的数据确实亮眼。

在公认的高难度数学竞赛基准 AIME 2025 中,星火 X2 拿下了 95.7 分的高分,这个成绩已经无限接近国际顶尖水平。在衡量综合能力的 MMLU Pro 测试中,也取得了 87.3 分的佳绩,在国产模型中处于领跑地位。

这种逻辑能力的跃升,直接对标的是 GPT-5.2 和 Gemini-3-Pro。

星火 X2 除了理科学霸的身份,还是个语言天才。它支持超过 130 种语言,并且特别针对拉美、东盟等区域的小语种进行了专项优化。

对于正在出海的中国企业来说,简直是自带翻译官。无论是跨境电商的客服,还是海外游戏的本地化运营,星火 X2 都能提供比通用模型更地道的语言支持。

三、教育医疗场景深度落地

相比于单纯卷参数,讯飞最擅长的还是落地。星火 X2 在专业场景上的优化,充满了浓浓的实用主义风格。

在教育领域,它不再是搜题机器。星火 X2 实现了启发式讲解和步骤级错题批改。搭载该能力的讯飞学习机,就像一个耐心的私教,不是直接甩给你答案,而是引导孩子一步步思考。

在医疗领域,讯飞晓医 APP 依托星火 X2,支持复杂的多轮问诊。它能看懂晦涩的体检报告,还能审核用药安全,目前该能力已经通过了权威医疗评测。

在汽车领域,智能座舱也迎来升级。星火 X2 提升了对模糊意图的理解能力,车机能听懂你的言外之意,回复也更加高情商。

此外,讯飞发布的星辰 Agent 平台,支持长时复杂任务和多工具调用,智能体(Agent)的执行效率直接提升了 3 倍以上。

四、百万 Token 免费领

技术再好,得让大家用起来。

讯飞宣布,星火 X2 的能力已全面上线讯飞星火网页版和 App。对于广大开发者和企业用户,讯飞开放平台提供了 API 接口,并直接给出了免费 100 万 Tokens 的体验额度。

这一举措无疑是在向开发者示好。

五、结语

短短三个月,从 X1.5 到 X2,讯飞展示了惊人的迭代速度。

如果说 DeepSeek 的爆发证明了中国算法团队的创新能力,那么讯飞星火 X2 的发布,则证明了国产算力底座和行业应用落地的坚实基础。

大模型的热潮正在褪去浮躁,进入拼刺刀的深水区。谁能用更低的成本、更高的效率、更实际的场景,真正为用户创造价值,谁才能在下半场站稳脚跟。

讯飞星火 X2,显然已经做好了准备。